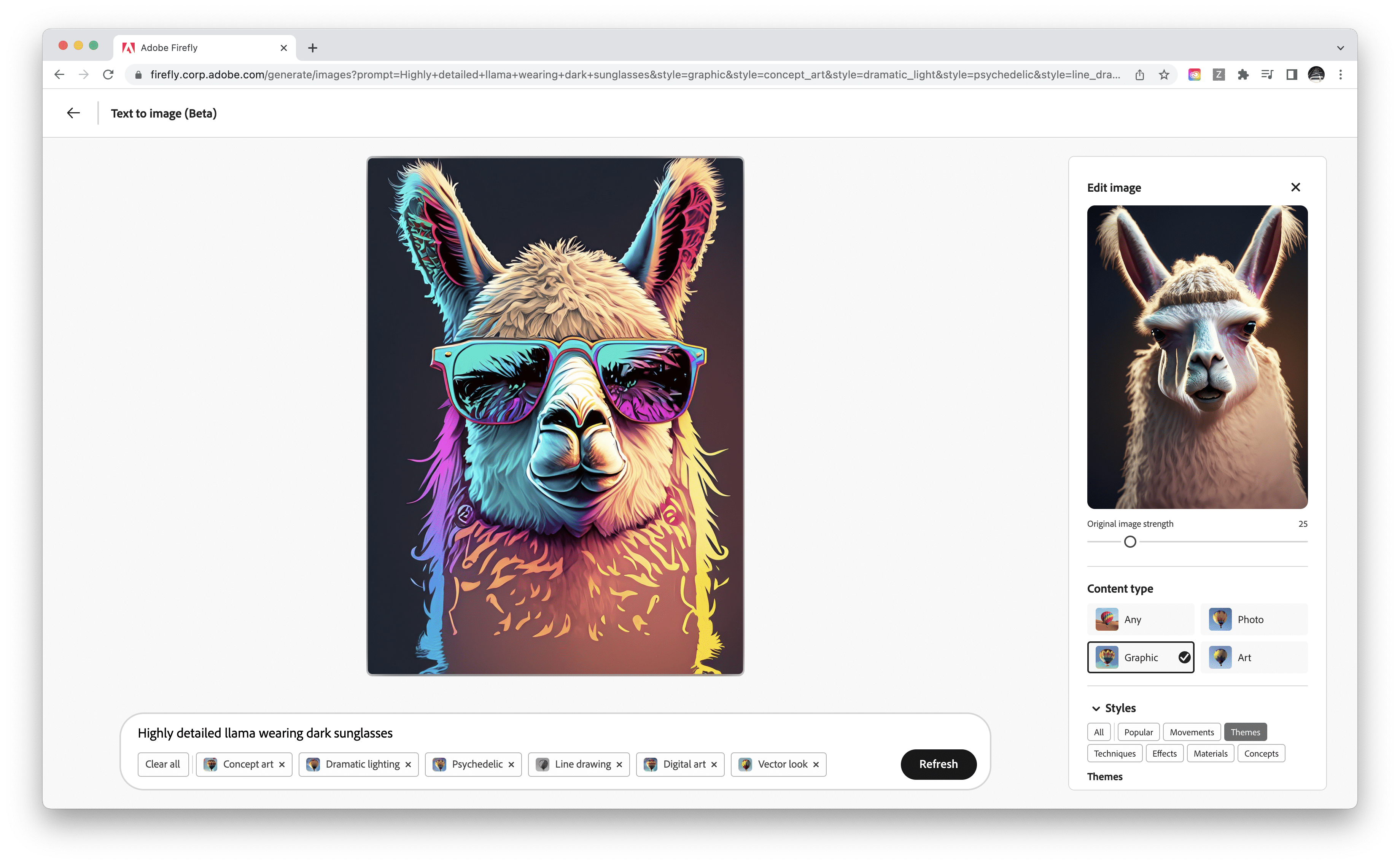

Synthographie für den Massengebrauch: Adobe launcht Firefly

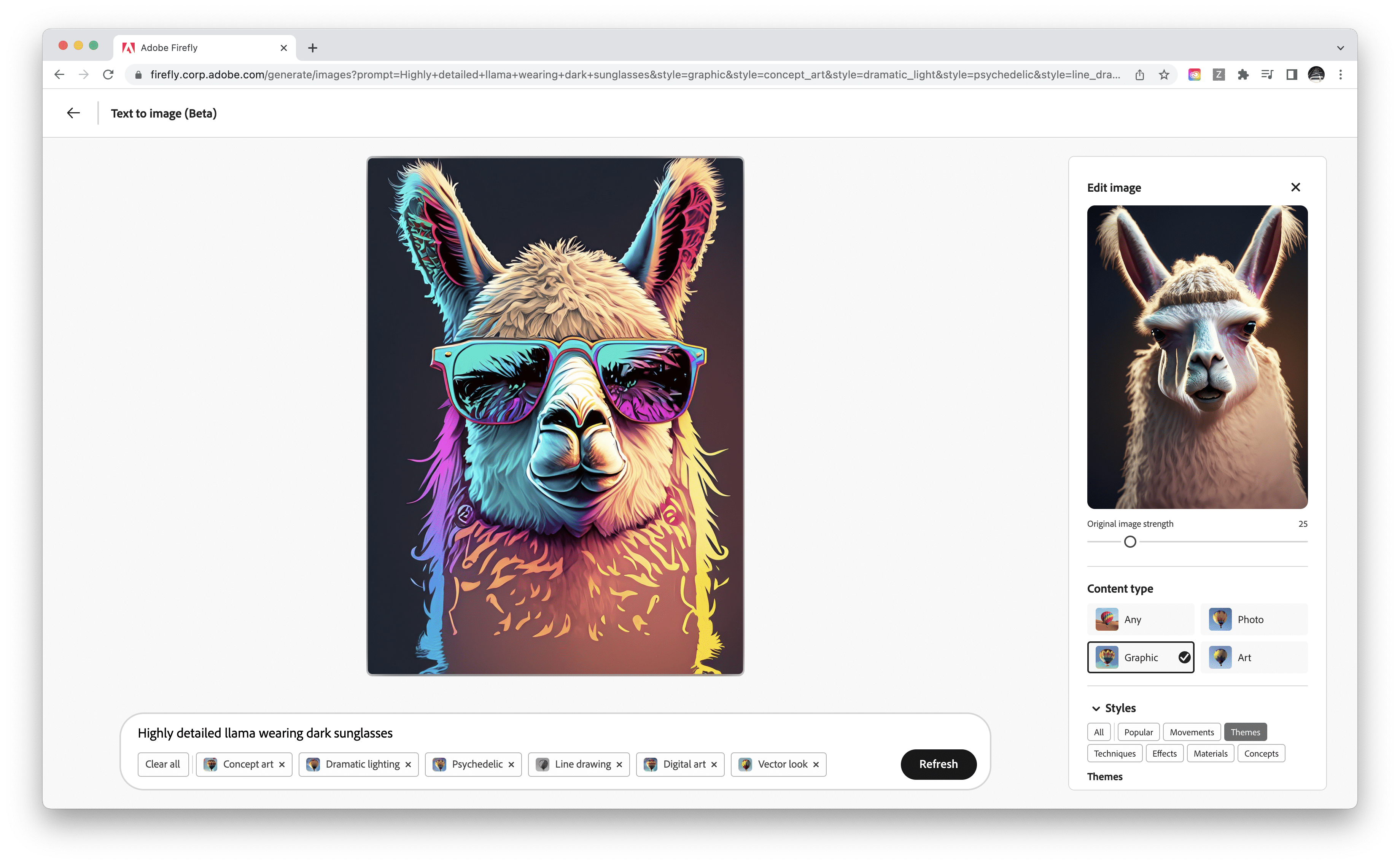

Adobe erweitert seinen KI-Dienst Sensei um eine Reihe generativer KI-Modelle. Die vom ersten Firefly-Modell erzeugten Bilder und Textelemente sollen vor allem rechtssicher für die kommerzielle Nutzung sein.

Das neue Firefly-Projekt steckt zwar noch in der Beta-Phase, aber mit Sensei sorgen »intelligente« Tools unter der Oberfläche von Adobe-Apps bereits seit Jahren für effizientere Workflows. So erleichtern etwa die Neural Filter in Photoshop oder der Content Aware Fill in After Effects den Arbeitsalltag, aber auch beim Durchsuchen von Adobe Stock kommt die Sensei-Intelligenz zum Einsatz.

Das neue Firefly-Projekt steckt zwar noch in der Beta-Phase, aber mit Sensei sorgen »intelligente« Tools unter der Oberfläche von Adobe-Apps bereits seit Jahren für effizientere Workflows. So erleichtern etwa die Neural Filter in Photoshop oder der Content Aware Fill in After Effects den Arbeitsalltag, aber auch beim Durchsuchen von Adobe Stock kommt die Sensei-Intelligenz zum Einsatz.

Rechts- und Textsicher: Firefly überzeugt Tester

Das erste Firefly-Modell wurde auf den lizenzierten Adobe Stock-Bildern trainiert, sowie auf offen-lizenzierten- und Public Domain-Inhalten, deren Copyright abgelaufen ist. So will man erreichen, dass vor allem rechtssicherer Content für die kommerzielle Nutzung entsteht und das geistige Eigentum anderer unangetastet, beziehungsweise der Markenschutz gewährleistet bleiben.

Die zukünftigen Firefly-Modelle sollen dann eine Vielzahl von Assets, Technologien und Trainingsdaten von Adobe sowie anderen Unternehmen nutzen. Was genau geplant ist, gab Adobe noch nicht bekannt, jedoch die ersten Apps, in denen die Firefly-Modelle integriert sein werden. So dürfen sich Nutzer:innen von Adobe Express, Adobe Experience Manager, Adobe Photoshop und Adobe Illustrator bald über die Unterstützung der generativen KIs freuen.

Einige Kreative und A.I.-Artists durften Firefly in den letzten Wochen bereits testen und teilen nun ihre Erfahrung mit dem Tool in Social Media. Die Möglichkeiten bei der Texterstellung scheinen zu begeistern. Eine Sache, die generative KIs wie Midjourney oder DALL-E nicht so gut beherrschen.

»Do Not Train«-Tag und KI-Kennzeichnung

Als Gründer der Content Authenticity Initiative (CAI) und Anbieter der sogenannten Content Credentials, einem Kennzeichnungswerkzeug für künstlerische Werke, will Adobe mit den Firefly-Integrationen dafür sorgen, dass KI-generierte Bilder zukünftig automatsich als solche getaggt werden.

Darüber hinaus sollen Kreative mit einem »Do Not Train«-Tag in den Content Credentials verlangen können, dass ihr Werk von Trainingsdatensätzen ausgeschlossen bleibt. Ob sich aggressive Scraping-Softwares und KI-Modelle von so einem Tag wirklich abhalten ließen, darf bezweifelt werden. Der ethisch gute und richtige Gedanke hinter den Content Credentials liegt aber auf der Hand.

Wir sind jedenfalls darauf gespannt, die Firefly-Modelle demächst selbst zu testen. Dafür anmelden kann man sich auf der Firefly-Website.

Anmerkung zur Headline: Der Begriff Synthography ist relativ neu und stammt von der Medienkünstlerin und Forscherin Elke Reinhuber. Synthography beschreibt die Methode, digitale Medien – vor allem Bilder, aber auch Musik oder Texte – durch maschinelles Lernen synthetisch zu erzeugen. Reinhubers Forschungspapier »Synthography – An Invitation to Reconsider the Rapidly Changing Toolkit of Digital Image Creation as a New Genre Beyond Photography« erschien 2022 beim Schweizer Springer-Verlag.

Mehr zum Thema KI und Design

Wir berichten regelmäßig über neue Entwicklungen rund um KI und Design. Hier haben wir einige Artikel aus den letzten Monaten für euch zusammengestellt. Bitte beachtet dabei, dass sich die Lage fast wöchentlich ändert und manche Inhalte nicht mehr aktuell sein können.

Dieser Beitrag ist erstmals am 22. März 2023 erschienen.

Das könnte dich auch interessieren

Das neue Firefly-Projekt steckt zwar noch in der Beta-Phase, aber mit Sensei sorgen »intelligente« Tools unter der Oberfläche von Adobe-Apps bereits seit Jahren für effizientere Workflows. So erleichtern etwa die Neural Filter in Photoshop oder der Content Aware Fill in After Effects den Arbeitsalltag, aber auch beim Durchsuchen von Adobe Stock kommt die Sensei-Intelligenz zum Einsatz.

Das neue Firefly-Projekt steckt zwar noch in der Beta-Phase, aber mit Sensei sorgen »intelligente« Tools unter der Oberfläche von Adobe-Apps bereits seit Jahren für effizientere Workflows. So erleichtern etwa die Neural Filter in Photoshop oder der Content Aware Fill in After Effects den Arbeitsalltag, aber auch beim Durchsuchen von Adobe Stock kommt die Sensei-Intelligenz zum Einsatz.