AR war bisher nur im Zusammenhang mit unbewegten Bildinhalten möglich. Jetzt revolutioniert eine neue AR-Technologie Homeshopping und In-Store-Erlebnisse. Wie funktioniert Video-triggered Augmented Reality?

An Augmented-Reality-Objekte, die an Bilder, Marker oder wie bei »Pokémon GO« an Geomarker gekoppelt sind, haben wir uns gerade gewöhnt, da wartet das Münchener Start-up eyecandylab bereits mit einer neuen Technologie auf: Video-triggered AR knüpft AR-Objekte an Bewegtbilder, sodass TV, Kino, Public Viewing, In-Shop-Events oder auch YouTube-Videos eine ganz neue Dimension der User Experience erhalten können.

Erste echte Use Cases sind schon da

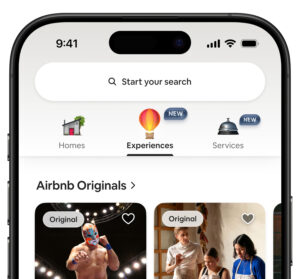

Die eyecandylab-Developer setzen Frame-genaue Triggerpunkte im Video und verknüpfen sie mittels Objekterkennung und Timecode mit AR-Elementen aus der eyecandylab-Datenbank. Die AR-App basiert auf dem mit der 3D-Entwicklungsplattform Unity realisierten augmen.tv SDK und funktioniert plattformübergreifend. Das AR-Erlebnis können User also sowohl über Apps mit ARCore für Android-Smartphones als auch mit ARKit für Apple-Geräte abrufen.

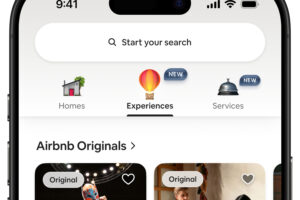

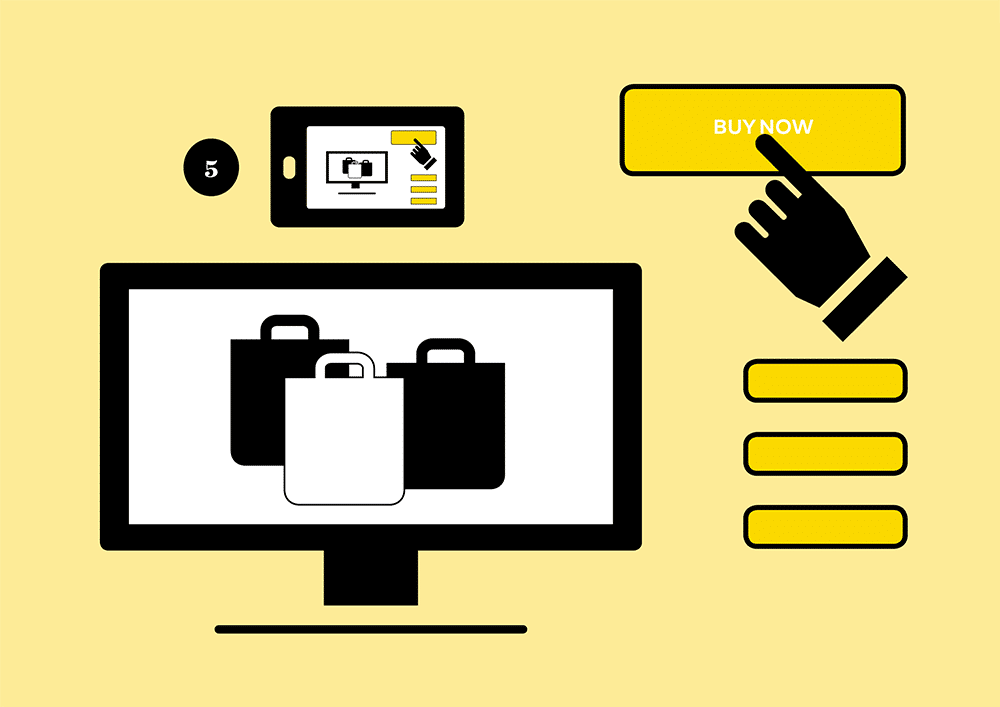

»Nach rund zwei Jahren Entwicklungszeit kam unsere Technologie im Oktober 2019 erstmals bei dem südkoreanischen Mobilfunkanbieter LG Uplus zum Einsatz«, sagt Robin Sho Moser, CEO und Mitbegründer von eyecandylab. Zuschauer der drei größten südkoreanischen Homeshopping-Kanäle GS Home Shopping, Lotte Homeshopping und Home & Shopping konnten mithilfe der App U+ AR Shopping ausgewählte Artikel aus den laufenden Sendungen heraus über Smartphone oder Tablet als AR-Objekte in die reale Wohnumgebung stellen. »Als führender Anbieter von innovativen Diensten im 5G-Bereich sind wir begeistert, unseren Kunden relevante Anwendungsfälle anbieten zu können«, sagt Keeman Seoh, Vice President von LG Uplus. Die Technologie von eyecandylab war ein willkommenes Differenzierungsmerkmal zur Mobilfunkkonkurrenz.

Neben der Anreicherung von Live-TV-Sendungen im Shopping- oder Sportbereich (siehe unten) drängen sich weitere Use Cases für Video-triggered AR geradezu auf. So könnten Augmented-Reality-Elemente auch Dokumentationen, Naturfilme oder Nachrichten bereichern und damit den Medienbruch zum Second Screen schließen, indem sie zusätzliche Informationen unmittelbar visualisieren.

Storytelling am Point of View

Ein weiterer vielversprechender Anwendungsbereich ist das Erlebnisshopping. Nicht nur das Zukunftsinstitut in Frankfurt am Main sieht ganz neue Chancen für den stationären Handel – auch adidas nutzt bereits Video-triggered AR, um das Einkaufen in der Fläche attraktiver zu gestalten – etwa im neuen Flagship-Store an der Pariser Champs-Élysées.

Zur Einführung der Produktlinie Parley im November 2019, die adidas in Kooperation mit der Umweltinitiative Parley for the Oceans komplett aus Meeresplastik herstellt, installierte adidas einen riesigen Bildschirm im Flagship-Store. Auf ihm kreuzt ein virtueller Wal die Weltmeere. Nur der viele Plastikmüll stört die Idylle. Also fordert der Vorspann des Videos die Kunden auf, eine App herunterzuladen, um damit Plastikflaschen und -tüten, Fischernetze, Taue und alte Flipflops aus dem Video einzusammeln. In der App kann der User sehen, wie der gesammelte Müll zu einem Partikelregen zerstoßen und dann zu einem Faden versponnen wird, aus dem am Ende der neueste Sneaker der adidas-Kollektion Parley entsteht.