So schützt ihr eure Arbeiten auf der eigenen Website vor Data-Scraping. Mit Step by Step Anleitung.

Laut dem kürzlich verabschiedeten AI Act müssen KI-Anbieter künftig mehr Transparenz bei ihren Trainingsdaten walten lassen und außerdem ein maschinenlesbares Opt-out ermöglichen. Aber wie genau das aussehen soll ist nicht definiert.

Laut dem kürzlich verabschiedeten AI Act müssen KI-Anbieter künftig mehr Transparenz bei ihren Trainingsdaten walten lassen und außerdem ein maschinenlesbares Opt-out ermöglichen. Aber wie genau das aussehen soll ist nicht definiert.

Was ist ein Opt-out?

Ein Opt-out ist einfach gesagt der Hinweis für Daten-Crawler, dass die Bilder auf einer bestimmten Website nicht verwendet werden dürfen. Dieser ist in der Regel in den Website-Code integriert. Wie genau das geht erklären wir euch unten im Step by Step.

Um die eigenen Bilder vom KI-Training auszuschließen müssen Opt-out-Hinweise für die Crawler der verschiedenen Unternehmen angelegt werden. Der Nachteil: alle Crawler, die nicht explizit ausgeschlossen werden, haben weiterhin Zugriff.

Kann ich meine Bilder direkt vor KI schützen?

Bisher leider nein. Das ist gerade dann ein Problem, wenn diese Bilder außerhalb der eigenen Website veröffentlicht, oder etwa per Screenshot vervielfältigt, heruntergeladen und anderweitig geteilt werden.

Auf Social Media sind die eigenen Bilder ungeschützt, außer die Plattform-Betreiber schließen Data-Crawler explizit aus. Das ist aber nur selten der Fall, denn oftmals sind Crawler erforderlich, um die eigenen Algorithmen zu trainieren und Google-Suchbarkeit zu gewährleisten.

Verschiedene Teams arbeiten dafür gerade an einer bildspezifischen Lösung. Etwa die Content Authenticity Intiative, die sich dafür einsetzt, dass Bilder eine eigene ID erhalten, in der sogar Bearbeitungsschritte festgehalten werden sollen.

Oder das Forschungsprojekt der University of Chicago, in dem Studierende ein neues Programm entwickeln, das Artworks für KI unlesbar machen soll.

Ist ein Opt-out sinnvoll?

Hier scheiden sich die Geister. Natürlich ist klar, dass Kreative ihre Arbeiten vor unrechtmäßiger Nutzung schützen wollen – oder zumindest eine Vergütung für die Nutzung ihrer Werke fordern. Aber nach aktueller Rechtslage ist Data-Scraping zu KI-Trainingszwecken erlaubt, sagt der Urheberrechtsanwalt Dr. Till Kreutzer im Interview zum Impuls: Doing KI.

Er wirft außerdem einige fast schon philosophische Fragen auf. Etwa, was den eigenen Stil ausmacht, ob dieser schützenswert ist, und ob Stile zu schützen nicht eher die Gestaltung einschränken würde. Ähnlich betrachtet er das Thema Opt-out.

Denn wollen wir nicht eigentlich eine KI, die von so vielen Werken wie möglich lernt, um ein möglichst diverses Bild von Kunst und Design zu erhalten? Diese Entscheidung bleibt jeder und jedem selbst überlassen – wichtig ist nur, diese Fragen offen zu diskutieren und als Kreativbranche solidarisch vorzugehen.

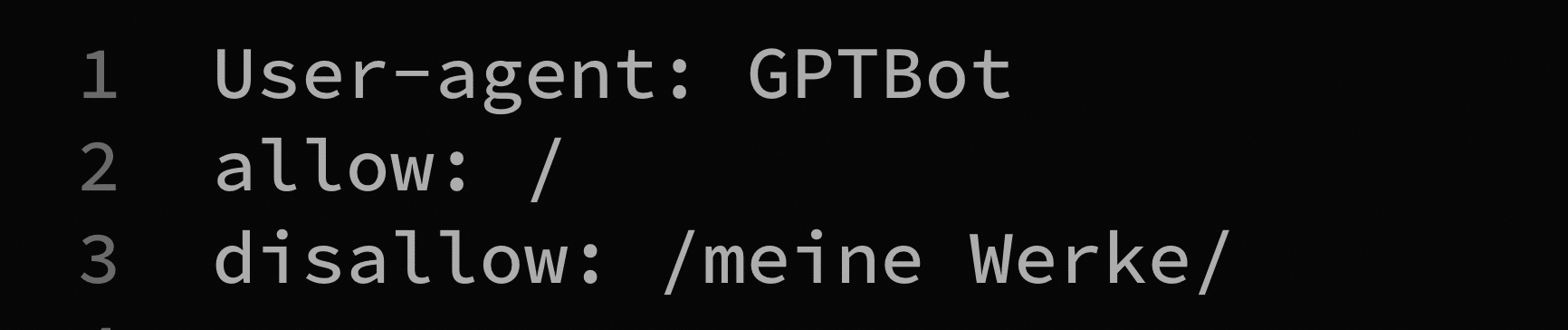

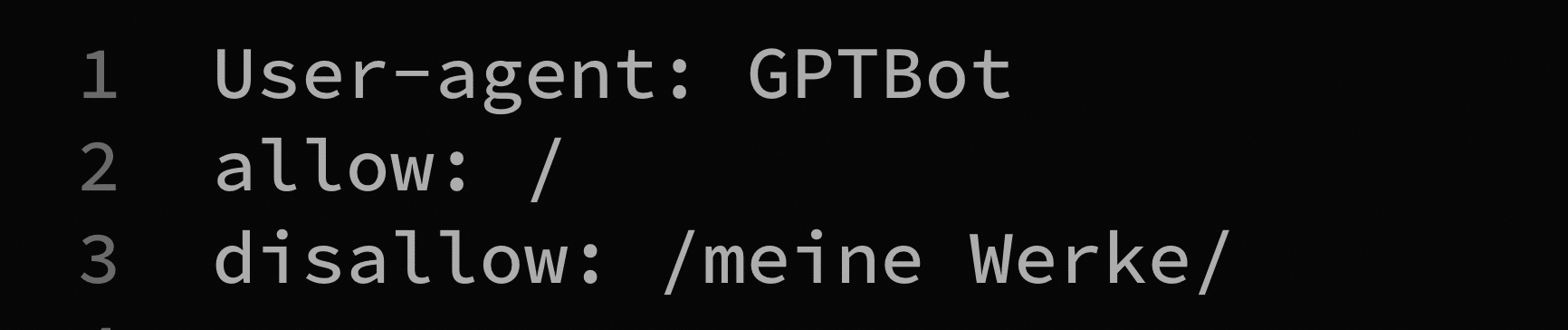

Step by Step: How to Opt-out mit robots.txt

Es gibt mehrere Wege, einen Opt-out vorzunehmen. Etwa mit CAPTCHAS, die den Zugriff auf bestimmte Bereiche deiner Website für Bots abriegeln oder dynamisches Laden von kritischen Inhalten. Die häufigste verwendet die »robots.txt« Datei im Website Code, um bestimmte Crawler von der eigenen Seite auszuschließen. Wir zeigen euch, wie´s geht.

Laut dem kürzlich verabschiedeten AI Act müssen KI-Anbieter künftig mehr Transparenz bei ihren Trainingsdaten walten lassen und außerdem ein maschinenlesbares Opt-out ermöglichen. Aber wie genau das aussehen soll ist nicht definiert.

Laut dem kürzlich verabschiedeten AI Act müssen KI-Anbieter künftig mehr Transparenz bei ihren Trainingsdaten walten lassen und außerdem ein maschinenlesbares Opt-out ermöglichen. Aber wie genau das aussehen soll ist nicht definiert.