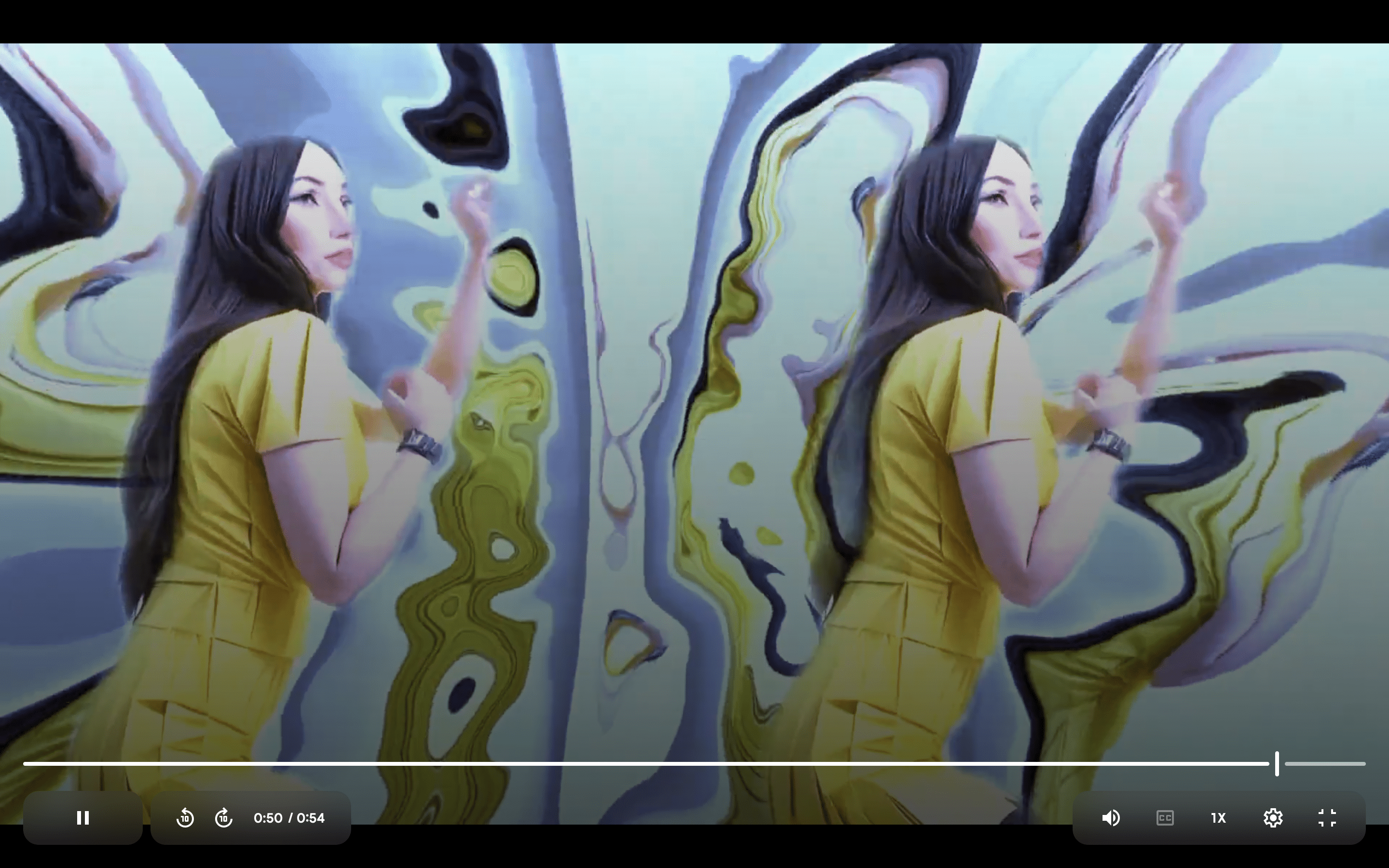

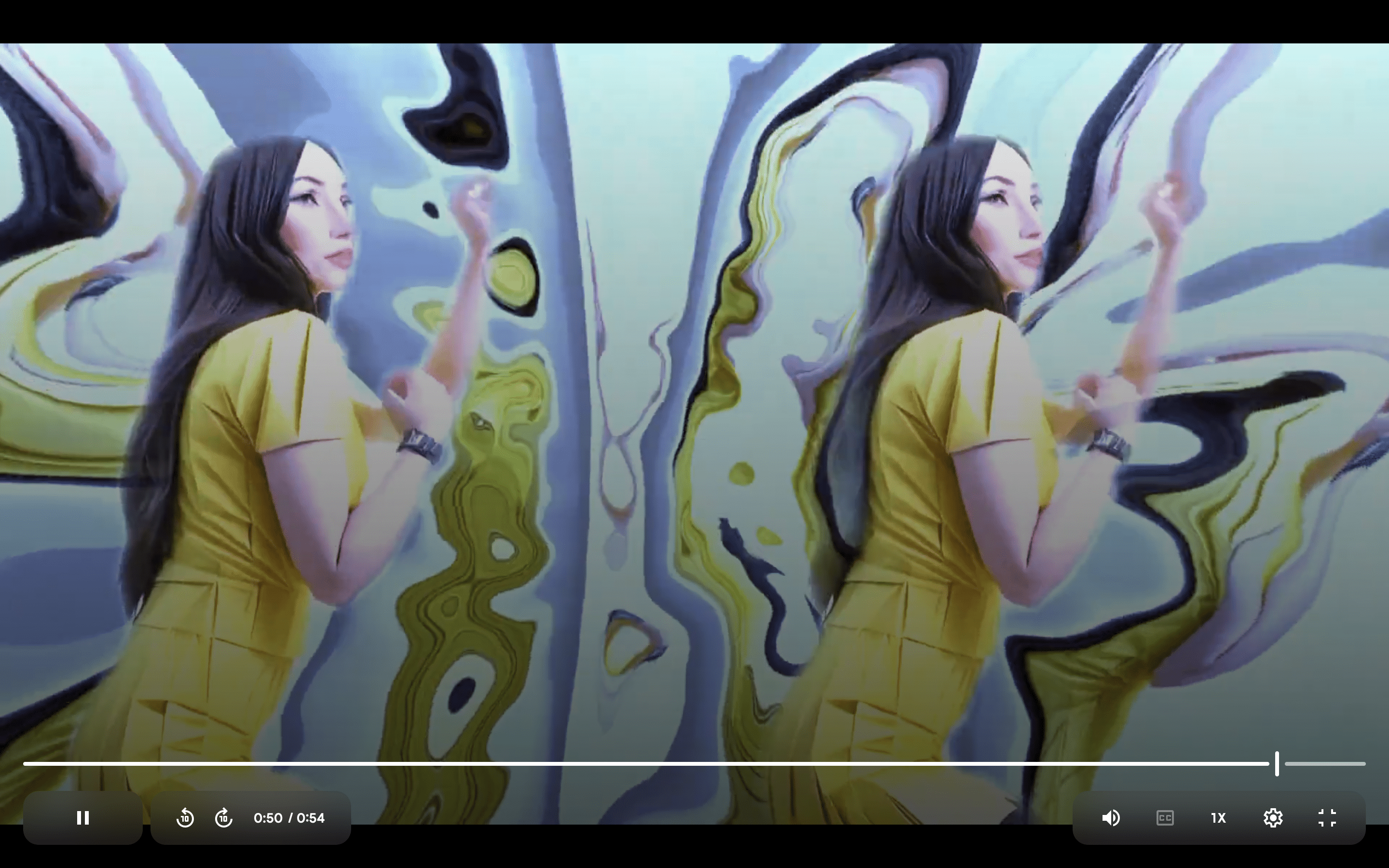

Machine Dream by Kadine James x Jessica Avarello 2024 ist eine der ersten digitalen Fashion-Installationen, die ausschließlich mit AI-Tools entstand. Welche Tools sie für das immersive Erlebnis nutzten, lest ihr in unserem Making-of

Basierend auf einem transmedialen KI-Workflow erforschen Kadine James und Jessica Avarello, wie virtuelle Identitäten mit unseren Vorstellungen von uns selbst verschmelzen. Dabei sind diese digitalen Identitäten nicht statisch, sondern tanzen und bewegen sich so wie ihre physischen Vorbilder. Wo diese Grenze zwischen virtuell und real verschwimmen, schaffen die Künstler:innen anlässlich der Digital Fashion Week eine transformative Erfahrung für das Publikum.

Basierend auf einem transmedialen KI-Workflow erforschen Kadine James und Jessica Avarello, wie virtuelle Identitäten mit unseren Vorstellungen von uns selbst verschmelzen. Dabei sind diese digitalen Identitäten nicht statisch, sondern tanzen und bewegen sich so wie ihre physischen Vorbilder. Wo diese Grenze zwischen virtuell und real verschwimmen, schaffen die Künstler:innen anlässlich der Digital Fashion Week eine transformative Erfahrung für das Publikum.

Was sie dazu bewegt hat? Die rigiden Schönheitsideale in der traditionellen Modewelt, die verhindern, dass man die eigene Persönlichkeit in all ihren Facetten ausdrücken kann. Machine Dream will die Klischees aufbrechen und eine neue, vielfältigere Vision von Identität zeigen, die fluide ist und sich im digitalen Raum nicht nur voll entfalten, sondern physische Einschränkungen überwinden kann.

»Wir haben aus Bildern von uns selbst virtuelle Modelle und digitale Persönlichkeiten entwickelt, die konventionelle Schönheitsstandards sprengen und zeigen sollen, was man durch seine digitalen Identitäten ausleben kann. Es geht darum, sich selbst zu feiern, sich auszudrücken und dabei die Freiheit des digitalen Raums auszukosten«, erklärt Kadine James.

Alle Artikel im PAGE Impuls »Motion Design«

Überblick: Electric Dreaming: AI in Motion | Interview: Faktor Mensch im Motion Design | Ausprobiert: Animatic mit Midjourney und Pika AI| Making-of: Machine Dream | Top 15: Angesagte KI-Tools für Motion Design | Workflow: Die Lieblingstools von Motion Designer Markus Edmaier | Service: Was ist Motion Design und was sind die nächsten großen Schritte?

Konzept und Motion Design mit KI

Um eine nahtlose und transformative Erfahrung zu schaffen, wählte das Kollektiv einen Workflow mit verschiedenen KIs. Unter anderem sorgt MagicAnimate dafür, dass die Künstlerin ihren virtuellen Zwilling in Bewegung versetzen kann. »Wir wollten durch visuelle und choreografische Elemente eine kohärente und emotionale Erzählung in einem vollständig digitalen Setting entwickeln. Dabei kam es besonders darauf an, dass die Interaktionen zwischen mir und meinen digitalen Avataren fließend und immersiv wirken«, so James.

Basierend auf einem transmedialen KI-Workflow erforschen Kadine James und Jessica Avarello, wie virtuelle Identitäten mit unseren Vorstellungen von uns selbst verschmelzen. Dabei sind diese digitalen Identitäten nicht statisch, sondern tanzen und bewegen sich so wie ihre physischen Vorbilder. Wo diese Grenze zwischen virtuell und real verschwimmen, schaffen die Künstler:innen anlässlich der Digital Fashion Week eine transformative Erfahrung für das Publikum.

Basierend auf einem transmedialen KI-Workflow erforschen Kadine James und Jessica Avarello, wie virtuelle Identitäten mit unseren Vorstellungen von uns selbst verschmelzen. Dabei sind diese digitalen Identitäten nicht statisch, sondern tanzen und bewegen sich so wie ihre physischen Vorbilder. Wo diese Grenze zwischen virtuell und real verschwimmen, schaffen die Künstler:innen anlässlich der Digital Fashion Week eine transformative Erfahrung für das Publikum.