Fake to Face: So funktionieren Deepfake-Videos

Deepfake-Videos sind schon jetzt kaum von echten zu unterscheiden. Ihre Herstellung mit Künstlicher Intelligenz und Machine Learning wird auch die Arbeitsweisen von Agenturen bei der Entwicklung von Videos und Lokalisierungen nachhaltig verändern.

Anders als bei Fotos war es bis vor Kurzem sehr aufwendig, Videos fotorealistisch zu manipulieren. Doch spätestens seit dem Siegeszug von Machine Learning ist das vorbei: Mit KI-gestützten Werkzeugen lassen sich auch im Bewegtbild nahezu unbemerkt Gesichter austauschen oder auf andere Körper setzen – oder einer prominenten Person Worte in den Mund legen, die sie nie gesagt hat.

In PAGE 09.19 verraten wir, wie Deepfakes entstehen, wie sie sich aufspüren lassen und geben einen Überblick über Deepfake-Tools. Aber tatsächlich geht nicht immer nur um Betrug und Fälschung: In dem ausführlichen Artikel geben wir Einblick, wie KI und Machine Learning die Art und Weise verändern, wie Agenturen Videos produzieren und Bewegtbildkampagnen planen und umsetzen.

Künstliche Intelligenz interpretiert Mimik und Gestik

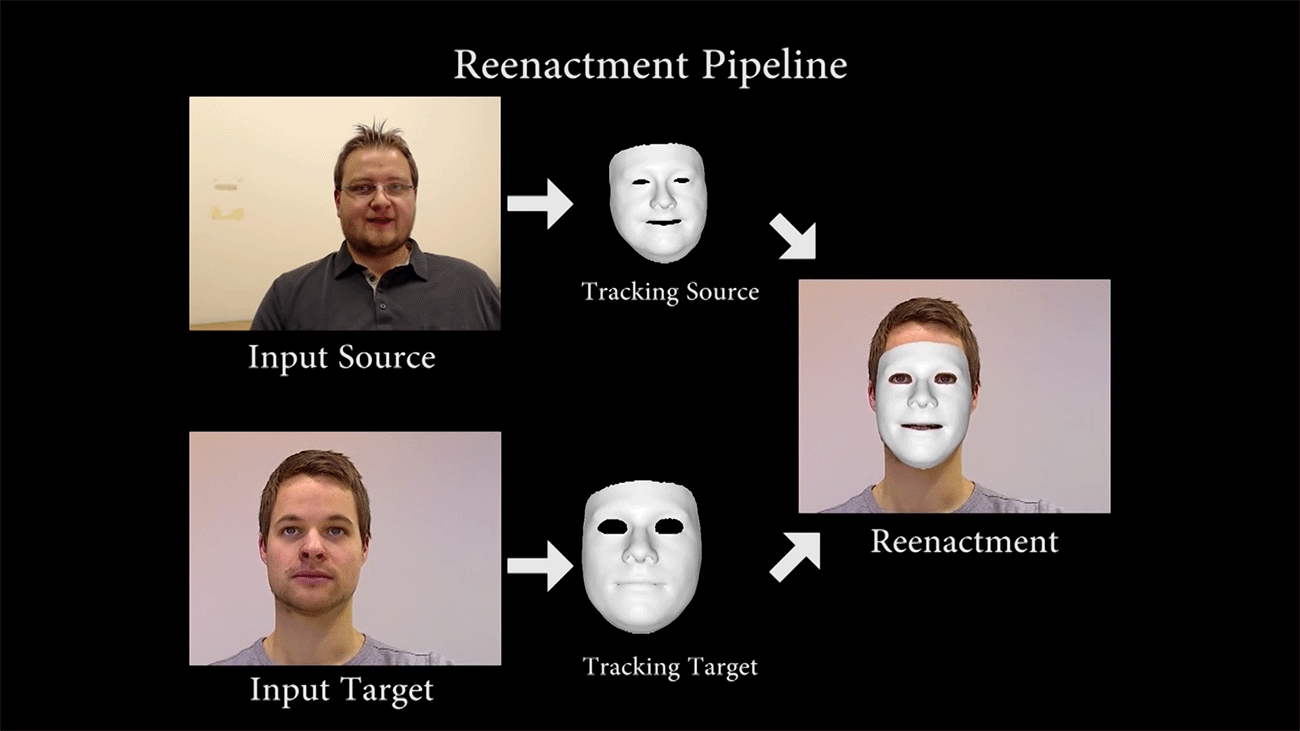

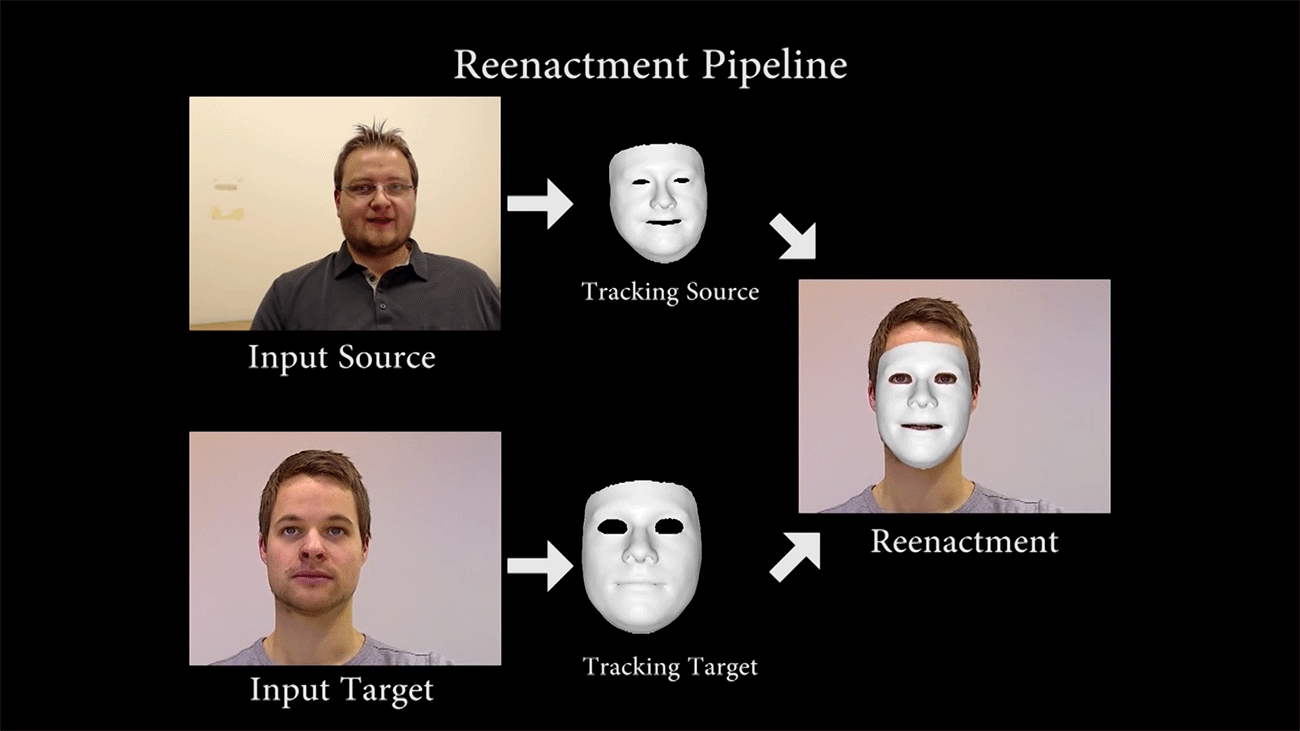

Wie der Face2Face-Algorithmus (Bild oben) funktioniert, demonstriert Forscher Justus Thies, der hier als Input Source fungiert. Die Zielperson (Input Target) zeigt sich mit neutralem Gesicht. Nachdem die KI die Mimik und Gestik der Input Source gelernt hat, kann sie diese mühelos mit einem 3D-Modell in Echtzeit auf das Input Target übertragen und nach den Vorgaben der Input Source in Echtzeit synchronisieren.

Noch tiefer in das Thema »Deepfake Videos« eintauchen – PAGE 09.2019 herunterladen

Beispiele für Deepfake-Anwendungen

Um besser vermitteln zu können, was mit Deepfake Videos bereits alles möglich ist, haben wir hier einige spannende Beispiele zusammengetragen.

Dank Fake-Video: David Beckham spricht 9 Sprachen

Die erste ernstzunehmende Deepfake-Kampagne realisierte die Digitalagentur R/GA London für die britische Non-Profit-Organisation Malaria No More. Technischer Support kam vom Londoner Deep-Learning- und KI-Experten Synthesia. Fußballstar David Beckham lieh der Kampagne sein Gesicht und spricht mit den Stimmen von neun Malaria-Überlebenden in Fremdsprachen, die er eigentlich nicht beherrscht. Möglich machte das ein von Synthesia produzierter Deepfake, in dem Beckhams Gesicht 3D-gerendert und im laufenden Video durch einen KI-Algorithmus mit der Mimik des jeweiligen Sprechers abgeglichen wurde. Mit bloßem Auge ist dies nicht zu erkennen – nur Beckhams Stimme wirkt auf einmal befremdlich.

nach oben

Mit Adobe After Effects und FakeApp: Obama disst Trump

Regisseur und Komiker Jordan Peele legt in diesem gemeinsam mit dem US-Newskanal BuzzFeed entwickelten Deepfake-Clip Ex-Präsident Obama Worte in den Mund, die er nie gesagt hätte, wie: Trump sei ein Vollidiot. Die glaubwürdige Fälschung ist mit Adobe After Effects und der FakeApp entwickelt worden – allein das Rendering soll 56 Stunden gedauert haben. Bei genauerem Hinsehen werden jedoch die Schwächen des KI-Algorithmus der kostenlosen und frei verfügbaren FakeApp deutlich. Für den professionellen Einsatz sind Schattenbildung und Genauigkeit der Synchronisation nicht ausgereift genug.

nach oben

»Spectre«: Deepfake-Algorithmus lässt Mark Zuckerberg gestehen

Das Deepfake-Video »Spectre« mit Mark Zuckerberg stammt von den britischen Künstlern Bill Posters und Daniel Howe. Der Deepfake-Algorithmus des israelischen Technologieunternehmens Canny AI lässt den Facebook-Chef öffentlich erklären, dass er Usern Daten stiehlt. Die Technologie des Algorithmus orientiert sich an Forschungen der Universität Washington und am Face2Face-Algorithmus. Gezeigt wurde die Zuckerberg-Fälschung erstmals auf dem Filmfestival Sheffield Doc/Fest im Juni 2019 und wurde rasend schnell über Instagram verbreitet. Dank Machine Learning wirkt das Filmchen frappierend echt.

nach oben

Lokalisierung dank Deepfake-Technologie: John Lennon vs. Hatred and War

Stell dir vor: Donald Trump, Wladimir Putin, Theresa May und Kim Jong Un singen gemeinsam »Imagine« von John Lennon – und meinen es tatsächlich so. Diesen Traum visualisierte das israelische Technologie-Start-up Canny AI, indem es den Weltführern den Song in den Mund legte. Was aussieht wie ein Spaß, demonstriert das Potenzial der Deepfake-Technologie. Der Algorithmus von Canny AI erlaubt professionelle Imitationen – ein Grund, warum die Israelis sich darauf spezialisiert haben, Film- und Videomaterial in jede Sprache zu synchronisieren, um die Lokalisierung zu erleichtern.

nach oben

Frei verfügbare KI-Software: Stallone vs. Schwarzenegger

Wie würde »Terminator 2« wohl mit »Rambo«-Darsteller Sylvester Stallone in der Hauptrolle aussehen? Das fragte sich der YouTuber Ctrl Shift Face, der in seinem stellenweise erstaunlich realistisch anmutenden Deepfake Arnold Schwarzenegger kurzerhand durch Sly ersetzte. Für die professionelle Veränderung von Videomaterial ist die frei verfügbare KI-Software DeepFaceLab, die der YouTuber für die Entwicklung verwendete, jedoch nicht ausgereift genug. Gerade bei wenig Beleuchtung sieht der Kopf doch sehr aufmontiert aus. Vielleicht liegt es aber auch daran, dass Ctrl Shift Face den KI-Algorithmus nicht lange genug mit Stallone-Fotos und -Videos

aus dem Internet gefüttert hat.

Anderer Versuch, gleiche Software: Bill Hader vs. Arnold Schwarzenegger

In der Talkshow Saturday Night Life des US-amerikanischen Senders bekam der US- amerikanische Komiker Bill Hader einen Lachkrampf, als er sich vorstellte, wie seine kleine Tochter Zitate des Schauspielers Arnold Schwarzenegger nutzen würde. Talkmaster Conan O’Brien und er kichern sich schließlich wie kleine Schuljungs durch die Sendung. Diese Sternstunde der Talkshows nutzte YouTuber Ctrl Shift Face für einen Deepfake und setzte Bill Hader immer dann Arnold Schwarzeneggers Gesicht ein, wenn dieser wieder einen Joke mit einem Zitat aus einem seiner Filme herausposaunte.

nach oben

Hochdetaillierte 3D-Gesichtsmodelle: Fake vs. Wahrheit

Auf der TED 2018 in Vancouver berichtete Ex-Google-Ingenieur Supasorn Suwajanakorn von der Entwicklung eines KI-Algorithmus, mit dem sich hochdetaillierte 3D-Gesichtsmodelle mit verschiedenen Ansichten rekonstruieren lassen, ohne die Person jemals in 3D zu scannen. Was bei Fotos schon lange möglich ist, funktioniert bei Videos, indem derselbe Algorithmus auf jedem einzelnen Videobild ausgeführt wird und ein bewegtes 3D-Modell erzeugt. Alle 3D-Modelle bewegen sich synchron zu Gestik und Mimik des ehemaligen US-Präsidenten George W. Bush.

Das könnte dich auch interessieren