Augmented Photography versus Projection Mapping

Der Berliner Künstler Frank Eickhoff hatte am ersten Juliwochenende auf der »Berlin Zimmer Genossen«-Ausstellung im Berliner Funkhaus Nalepastrasse eine weitere Installation mit seiner digitalen Lichtkunst vorgestellt. Für PAGE erklärt er seine Projektionstechnik der »Augmented Photography«.

Der Berliner Künstler Frank Eickhoff hatte am ersten Juliwochenende auf der »Berlin Zimmer Genossen«-Ausstellung im Berliner Funkhaus Nalepastrasse eine weitere Installation mit seiner digitalen Lichtkunst vorgestellt. Für PAGE erklärt er seine Projektionstechnik der »Augmented Photography«.

Was genau machst Du mit Deiner Lichtkunst?

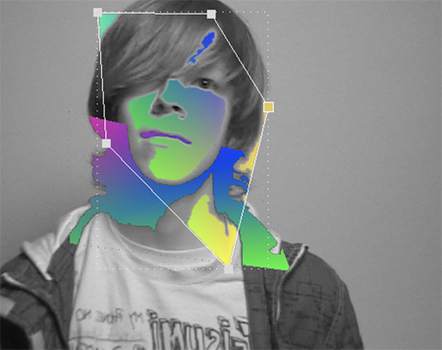

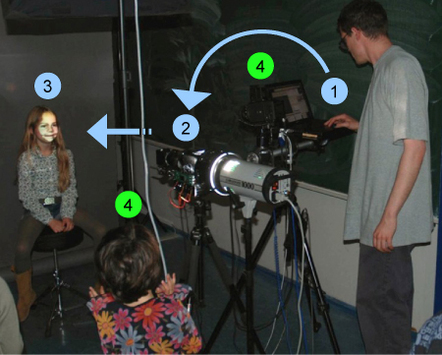

Ich habe eine Software geschrieben – eine Art Photoshop mit Video Input in Realtime -, die mit einem Video Beamer verbunden ist. Damit erzeuge ich Lichtffekte, die dann auf ein Objekt gemappt beziehungsweise angepasst und projiziert werden.

Wie bist Du auf Deine spezielle Technik gekommen?

Ich habe in Karlsruhe am ZKM Kunst studiert und mich damals mit aufwendigen Lichteffekten in der Fotografie beschäftigt. Das Problem ist dabei, dass solche Effekte alle manuell, mechanisch und statisch mit Farbfolien oder Schablonen eingestellt werden. Wenn man etwas an der Inszenierung verändert, muss man die ganze Lichtapparatur per Hand anpassen. Das ist natürlich sehr zeitaufwendig.

Die beschränkten mechanischen Möglichkeiten und der Zeit- beziehungsweise Kostenfaktor sind wohl auch ein Grund dafür, dass sich die Lichttechnik für Fotografie und Film seit vielen Jahrzehnten im Grunde nicht groß verändert hat. Stattdessen ging ja bekanntermaßen die Entwicklung hin zu einer Digitalisierung, in der sämtliche Effekte und Lichtatmosphären nachträglich in der Postproduktion hinzugefügt werden. Hier greift meine Idee, die Möglichkeiten der Computergrafik und seine Realtimefähigkeit für die Arbeit im Studio zu nutzen, also direkt am Objekt – dort wo das Foto, der Film oder etwas anderes entsteht.

Bitte erkläre das genauer!

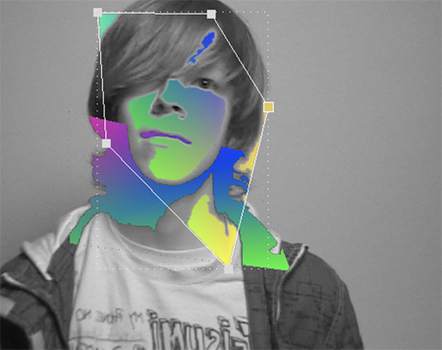

Ich habe eine Software geschrieben mit der ich Lichteffekte erzeugen kann, die sich der Form des zu beleuchtenden Objektes anpassen. Die Software funktioniert ähnlich wie ein Grafikprogramm wie etwa Photoshop. Anfang 2007 war das ganze noch als Fotoblitz geplant, inzwischen geschieht das alles mit Laptop und Beamer. In der Architektur-Beleuchtung gibt es übrigens ein ganz ähnliches Verfahren unter dem Begriff: Projection Mapping. Im Unterschied dazu arbeitet meine Software in Echtzeit, das bedeutet, der Effekt wird ständig neu berechnet und passt sich Bewegungen und Veränderungen quasi automatisch an.

Und diese Technik verstehst Du unter »Augmented Photography«?

Ich habe das Verfahren »Augmented Photography« genannt, als Mischung aus »Computational Photography« und »Augmented reality«. Als Computational Photography beschreibt man in der Informatik Weiterentwicklungen von Fotokameras, Optik und Aufnahmeverfahren – jede Konsumenten-Kamera arbeitet übrigens mit solchen Algorithmen. Augmented Reality rekonstruiert aus 2-D-Videobildern eine 3-D-Perspektive und Geometrie. Dieses Verfahren ist mit dem »Match Moving« oder anderen filmischen Effekten vergleichbar.

Und wie setzt Du diese Software künstlerisch um?

Ich benutze das Tool für meine künstlerischen Arbeiten und erstelle Fotos und Installationen. Grundsätzlich bin ich aber auch offen für Kollaborationen. Ich habe etwa mein Projekt Jörg Koch vom Magazin 032c vorgestellt, entwickle im Moment mit Experimentalpop-Sängerin Janine Rostron von Planningtorock eine neue Bühnenshow und hatte neulich ein Projekt bei der Agentur WHITEvoid.

Danke für das Gespräch!

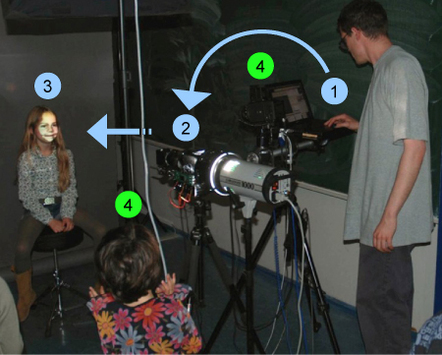

Bilderklärung: 1 = Effekt Software 2 = Effekt Projektion 3 = Modell 4 = Aufnahme (Foto, Video) oder Betrachter

Das könnte dich auch interessieren